Sur ChatGPT

Le principal danger des IA, c’est qu’on les prennent pour ce qu’elles ne sont pas. C’est de croire qu’elles possèderaient une connaissance illimitée sur tous les sujets, c’est de croire qu’elle possèderaient une intelligence supérieure qui les rendraient infaillibles.

Plein de gens ont intérêt à ce que vous croyiez ça. Parce qu’ils ont des trucs à vous vendre. Des logiciels pour remplacer vos employés, essentiellement. Des logiciels pour corriger vos textes sans avoir à payer de secrétaire, des logiciels pour faire des illustrations sans avoir à payer un graphiste, des logiciels pour écrire des articles sans avoir à payer des journalistes, des logiciels pour analyser des CV sans avoir à payer un service de ressources humaines, des logiciels pour rendre la justice sans avoir à payer ni juges ni avocats et même, c’est vertigineux, des logiciels pour écrire des logiciels.

Mais les IA génératives à la mode en ce moment, comme ChatGPT, ne savent rien faire de tout cela. Ces logiciels sont impressionnants, ils réussissent haut la main le test de Turing, ils peuvent faire illusion pour un observateur naïf, mais ils ne sont absolument rien d’autre (comme leur nom l’indique) que des générateurs aléatoires sophistiqués. Littéralement, ce sont des logiciels qui tirent des mots au hasard dans un chapeau.

Si vous demandez à ChatGPT qui a écrit le Boléro, il vous répondra Ravel. Pourquoi ? Parce qu’on lui a donné à digérer une quantité astronomique de textes dans toutes les langues et que dans ce corpus gigantesque, la probabilité que le mot « boléro » soit suivi par le mot « Ravel » est grande, alors que la probabilité qu’il soit suivi par le mot « Debussy » ou « Beethoven » est nulle. Alors quand vous lui parlez de boléro, ChatGPT consulte ses tables statistiques, il regarde ce qui est le plus probable, et il vous répond Ravel. Il ne fait rien de plus que ça. Il n’implémente aucun algorithme de représentation des connaissances. (Enfin rien de très poussé, disons.) Il ne sait pratiquement rien. Il ne sait pas ce qu’est un boléro ni qui est Ravel, ce sont juste pour lui des unités lexicales sans valeur sémantique.

C’est de la même façon qu’il écrit un français correct. Il n’a aucune connaissance de l’orthographe ou des règles grammaticales. (Même si sa sortie passe probablement par un correcteur performant pour éliminer les éventuelles fautes résiduelles.) Il reproduit juste les schémas statistiques qu’il a appris en lisant beaucoup de textes. Si on lui avait donné à bouffer du français plein de fautes de syntaxe, il produirait des textes plein de fautes de syntaxe. Coïncidence amusante : j’ai travaillé sur ce genre de modèle de langage, c’était il y a plus de vingt ans, et c’était pour un logiciel de dictée vocale. On faisait bouffer des gigaoctets de littérature à un modèle statistique dans l’espoir qu’ensuite, quand on prononçait /po/ /to/ /roz/ dans le micro, le logiciel de dictée écrive bien « pot-aux-roses » et non « poteau rose »…

Et même si ChatGPT pouvait se représenter des connaissances, il n’implémente pas non plus d’algorithme d’inférence logique pour en tirer des déductions. La preuve : les réseaux sociaux regorgent de copies d’écrans moqueuses où l’on voit une IA dire un truc et son contraire immédiatement après. Et hormis quelques cas simples, quand on l’utilise pour écrire du code, le code produit ne marche généralement pas.

Quel est le problème, alors ?

D’une part, en l’état actuel de l’art, ces logiciels sont stupides. Ce ne sont pas des bases de connaissance, ils sont incapables faire des déductions logiques. Autrement dit : ils sont hautement faillibles. Il n’y a pas davantage de vérité, de logique ou de sens moral dans un texte produit par une IA générative que dans un horoscope astrologique. Le danger n’est pas que ChatGPT soit intelligent, le danger est que suffisamment de gens le croient pour qu’au nom de la performance, du coût ou de la suppression des boulots pénibles, il remplace l’humain dans des domaines critiques.

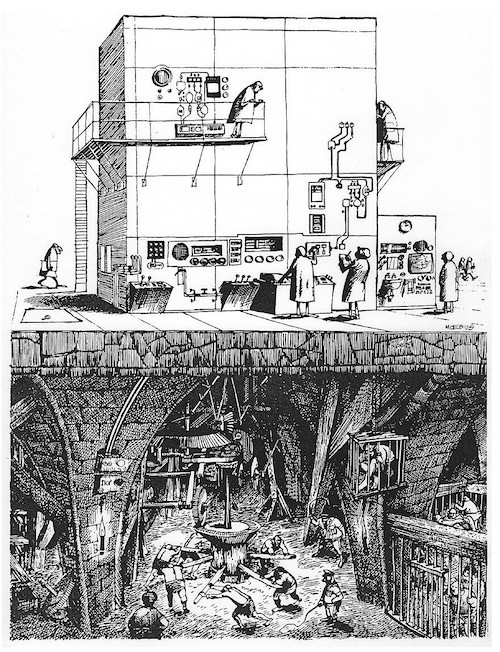

D’autre part, ces IA doivent être entraînées. Elles ne font que produire aléatoirement des textes ressemblant à ceux dont on l’a nourrie. Si on les entraîne sur des textes bancals, elles produisent des textes bancals. Il y a donc tout un travail préalable de mise en forme, de conditionnement des données d’apprentissage. Pour l’avoir déjà fait pour le logiciel de dictée vocale dont je parlais, je peux vous dire que c’est un travail d’esclave. Ce sont des giga-octets de textes à lire pour en corriger toutes les fautes, en supprimer toutes les informations sensibles (noms, numéros de téléphone, adresses…), en uniformiser la présentation, etc. Et comme d’habitude quand il y a un boulot pourri à faire, c’est fait par des gens sous-payés et traités comme de la merde.

Enfin, se pose la question du plagiat. Les IA génératives ne créent rien, elles imitent. Elles sont très douées pour ça, mais ça reste de la simple imitation. Qu’en est-il du respect de la propriété intellectuelle des auteurs qui ont produit les textes sur lesquels l’IA a été entrainée ? Et aussi, dans un monde où beaucoup se satisfont de médiocrité, qui va vouloir encore payer des artistes qui travaillent lentement et exigent un salaire alors que ChatGPT produit de la prose acceptable au kilomètre pour un coût dérisoire ?